"LinearRegression" (機械学習メソッド)

- Predictのためのメソッドである.

- 特徴の線形結合を使って値を予測する.

詳細とサブオプション

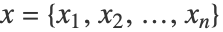

- 線形回帰は数値的特徴

を組み合せることで数値出力 y を予測する.条件付き確率

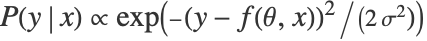

を組み合せることで数値出力 y を予測する.条件付き確率  は

は  に従ってモデル化される.ただし,

に従ってモデル化される.ただし, である.

である. - パラメータベクトル θ の推定は,損失関数

![1/2sum_(i=1)^m(y_i-f(theta,x_i))^2+lambda_1sum_(i=1)^nTemplateBox[{{theta, _, i}}, Abs]+(lambda_2)/2 sum_(i=1)^ntheta_i^2 1/2sum_(i=1)^m(y_i-f(theta,x_i))^2+lambda_1sum_(i=1)^nTemplateBox[{{theta, _, i}}, Abs]+(lambda_2)/2 sum_(i=1)^ntheta_i^2](Files/LinearRegression.ja/5.png) を最小にすることで行われる. m は例の数,n は数値的特徴の数である.

を最小にすることで行われる. m は例の数,n は数値的特徴の数である. - 次は,使用可能なサブオプションである.

-

"L1Regularization" 0 損失関数中の  の値

の値"L2Regularization" Automatic 損失関数中の  の値

の値"OptimizationMethod" Automatic 使用する最適化メソッド - "OptimizationMethod"オプションの可能な設定には次がある.

-

"NormalEquation" 線形代数メソッド "StochasticGradientDescent" 確率勾配メソッド "OrthantWiseQuasiNewton" 象限ごとの擬似ニュートンメソッド - このメソッドについては,Information[PredictorFunction[…],"Function"]は特徴から予測値を計算する簡単な式を与える.