"LogisticRegression" (機械学習メソッド)

- Classifyのためのメソッドである.

- 特徴の線形結合のロジスティック関数でクラス確率をモデル化する.

詳細とサブオプション

- "LogisticRegression"は,数値的特徴

,

,  の線形結合で各クラスの対数確率をモデル化する.ただし,

の線形結合で各クラスの対数確率をモデル化する.ただし, はクラス k のパラメータに対応する.パラメータ行列の推定

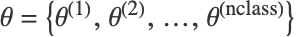

はクラス k のパラメータに対応する.パラメータ行列の推定  は,損失関数

は,損失関数 ![sum_(i=1)^m-log(P_(theta)(class=y_i|x_i))+lambda_1 sum_(i=1)^nTemplateBox[{{theta, _, i}}, Abs]+(lambda_2)/2 sum_(i=1)^ntheta_i^2 sum_(i=1)^m-log(P_(theta)(class=y_i|x_i))+lambda_1 sum_(i=1)^nTemplateBox[{{theta, _, i}}, Abs]+(lambda_2)/2 sum_(i=1)^ntheta_i^2](Files/LogisticRegression.ja/5.png) を最小化することで行われる.

を最小化することで行われる. - 次は使用可能なオプションである.

-

"L1Regularization" 0 損失関数中の  の値

の値"L2Regularization" Automatic 損失関数中の  の値

の値"OptimizationMethod" Automatic 使用するメソッド - "OptimizationMethod"の可能な設定には次がある.

-

"LBFGS" 有限メモリのBroyden–Fletcher–Goldfarb–Shannoアルゴリズム "StochasticGradientDescent" 確率勾配メソッド "Newton" ニュートンメソッド